Au cas où vous ne l’auriez pas encore remarqué Google a annoncé sur son blog pour webmasters une nouvelle version de son outil de test du fichier robots.txt : un outil entièrement renouvelé dans l’onglet Anciens rapports et outils. Cliquez ici pour accéder directement à l’outil de vérification des fichiers robots.txt.

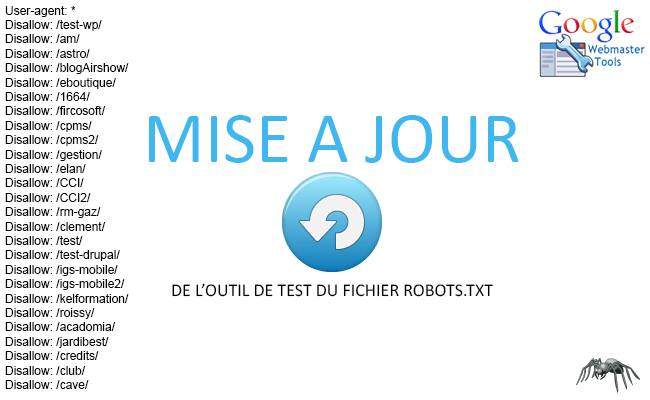

Le fichier robots.txt est un simple document texte qui est utilisé pour indiquer au Googlebot quelles sections d’un domaine peuvent être explorées par le robot du moteur de recherche et quelles sections doivent en être exclues. En outre, il est aussi possible d’y ajouter une référence au sitemap.XML.

Avant que le robot d’exploration commence l’indexation, il recherche tout d’abord le fichier robots.txt dans le répertoire racine et prend connaissance des instructions. C’est pourquoi le fichier texte doit être sauvegardé dans le répertoire racine d’un domaine et être nommé : robots.txt.

Grâce à la nouvelle mise à jour de Google, il est désormais possible de modifier directement votre fichier au sein de l’interface Google Search Console afin d’y effectuer des tests. Néanmoins, pour que les modifications prennent effet, il faudra suivre la procédure habituelle en remplaçant le fichier robots.txt d’origine par le nouveau côté serveur FTP.

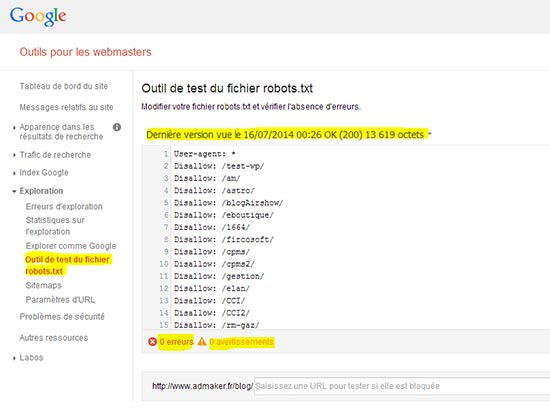

L’outil affiche également :

- La date et l’heure à laquelle le fichier a été vu pour la dernière fois,

- Le code http renvoyé par le fichier (un code 200 si tout va bien),

- La taille du fichier,

- Le nombre d’erreurs et d’avertissements

Enfin, l’outil permet de saisir une URL pour savoir si elle est bloquée. En cas d’URL bloquée, l’outil vous indiquera précisément quelle règle est à l’origine de ce blocage.

Tester votre fichier robots.txt

- Ouvrez l’outil de test pour votre site et faites défiler le code du

fichier robots.txtpour localiser les avertissements relatifs à la syntaxe et les erreurs de logique signalés. Le nombre d’avertissements relatifs à la syntaxe et d’erreurs de logique s’affiche immédiatement sous l’éditeur. - Saisissez l’URL de la page de votre site dans la zone de texte en bas de la page.

- Dans la liste déroulante à droite de la zone de texte, sélectionnez le user-agent que vous souhaitez simuler.

- Cliquez sur le bouton TEST pour tester l’accès.

- Vérifiez si le bouton TEST indique ACCEPTÉE ou BLOQUÉE pour savoir si nos robots d’exploration peuvent ou non explorer cette URL.

- Modifiez le fichier sur la page et testez de nouveau l’accès au besoin. Sachez que les modifications apportées à la page ne sont pas sauvegardées sur votre site. Reportez-vous à l’étape suivante.

- Copiez vos modifications dans le fichier robots.txt de votre site. Cet outil ne modifie pas le fichier qui se trouve réellement sur votre site. Il vérifie uniquement la copie hébergée sur l’outil.

Vous désirez optimiser le SEO de votre site web et acquérir plus de trafic ? Faites appel à nos experts SEO et bénéficiez d’une prestation de stratégie SEO complète ! Contactez-nous ! Et pour plus d’info sur le SEO et les bonnes méthodes pour l’optimiser, référez-vous à notre blog sur le SEO !